Lectura 3:00 min

Algoritmo de Facebook incentiva la confrontación

Documentos internos revelan reducción de costos en área de seguridad; Frances Haugen comparece en el Parlamento británico.

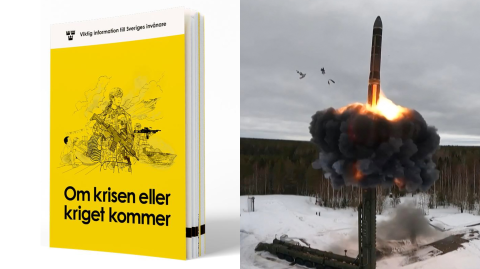

Frances Haugen, Facebook whistleblower, gives evidence to the UK Parliament

Londres. Facebook alentará más disturbios violentos en todo el mundo porque la manera en que sus algoritmos están diseñados ayuda a promover el contenido que fomenta la división, dijo el día de ayer 25 de octubre, la denunciante Frances Haugen en el Parlamento británico.

Haugen, exdirectora de producto del equipo de desinformación cívica de Facebook y que se ha convertido en denunciante, compareció ante una comisión parlamentaria británica que está examinando los planes para regular las empresas de redes sociales.

Haugen dijo que la red social veía la seguridad como un centro de costos, que ensalzaba una cultura de empresa emergente en la que recortar gastos era bueno, y que "sin duda" estaba agravando el odio.

"Los acontecimientos que estamos viendo en todo el mundo, como los de Myanmar y Etiopía, son capítulos iniciales porque una jerarquización basada en lo que atrae hace dos cosas: una, prioriza y amplifica el contenido extremo que divide y polariza, y dos, lo concentra", dijo.

Antes de la audiencia de ayer, Haugen se reunió con la ministra del Interior del país, Priti Patel, que aboga por una legislación más dura para las plataformas tecnológicas que no velen por la seguridad de los usuarios.

Haugen tiene previsto intervenir la semana que viene en una importante conferencia tecnológica, la Web Summit, a realizarse en Bruselas ante los responsables políticos europeos.

"Facebook no ha estado dispuesto a aceptar que se sacrifiquen incluso pequeñas ganancias por seguridad, y eso es inaceptable", dijo el día de ayer 25 de octubre, señalando el impacto de Instagram en la salud mental de algunos usuarios jóvenes.

Documentos internos de la firma vistos por Reuters muestran que Facebook sabía que no contrató suficientes trabajadores con las habilidades lingüísticas y el conocimiento de los eventos locales necesarios para identificar publicaciones objetables de usuarios en varios países en desarrollo.

Inteligencia artificial limitada

Los documentos también mostraron que Facebook emplea sistemas de inteligencia artificial para erradicar ese contenido que con frecuencia tampoco están a la altura. Asimismo, tampoco ha hecho fácil que sus propios usuarios globales marquen las publicaciones que violan las reglas del sitio.

Según advirtieron los empleados en los documentos, esas deficiencias podrían limitar la capacidad de la compañía para cumplir su promesa de bloquear el discurso de odio y otras publicaciones que infrinjan sus reglas en lugares desde Afganistán a Yemen.

En 2018, expertos de la ONU que investigaban una brutal campaña de asesinatos y expulsiones contra la minoría musulmana rohinyá de Myanmar dijeron que Facebook se usaba ampliamente para difundir discursos de odio hacia ellos.

Ashraf Zeitoon, exjefe de políticas de Facebook para Medio Oriente y África del Norte, quien se fue en 2017, dijo que el enfoque de la empresa para el crecimiento global era "colonial", centrado en la monetización sin medidas de seguridad.