Lectura 3:00 min

Google desarrolla IA que aprende sin intervención humana

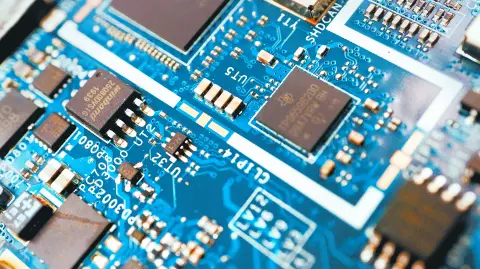

El algoritmo usa el reconocimiento de patrones a través de redes neuronales artificiales, que imitan el funcionamiento del cerebro humano, y que a base de reforzar las conexiones entre ellas logran que la máquina aprenda.

Foto: Reuters

¿Se imaginan derrotar al mejor jugador mundial del Go, el complejísimo ajedrez oriental creado hace más de 2.500 años, sin haber jugado nunca una partida, sin que nadie le haya enseñado las reglas del juego ni conocer el movimiento de las fichas?. Pues eso es lo que ha conseguido Google Deepmind, la división de inteligencia artificial del gigante buscador. Esta filial ya logró crear un programa, Alpha Go, que derrotó por primera vez a los campeones mundiales del juego en una serie de partidas que, dos décadas después de la victoria del superodenador de IBM Deep Blue, volvieron a escenificar el enfrentamiento entre hombre y máquina.

Esta vez, sin embargo, Google ha ido un paso más allá a la hora de explorar las fronteras de la inteligencia artificial. El equipo de Deepmind enfrentó a Alpha Go con su hermano mayor, Alpha Go Zero, un nuevo algoritmo que, sin necesidad de entrenamiento previo, ha sido capaz de aplastar a todas las versiones anteriores del programa sin ceder un solo punto en cien partidas y en un tiempo récord. Ningún humano ha sido capaz de desplegar una estrategia ganadora sobre el tablero de 19 por 19 cuadrante de este endiablado juego a una velocidad semejante y de forma tan implacable.

Nature

Lo verdaderamente revolucionario del algoritmo es que, mientras que la versión original de Alpha Go necesitó estudiar millones de movimientos reales de miles de partidas jugadas entre humanos, Alpha Go Zero ha aprendido de cero y sin ayuda de nadie. Como explican los responsables del estudio, publicado por la revista científica Nature, el aprendizaje del algoritmo se ha producido "sin datos humanos, orientación o conocimiento del juego más allá de sus reglas". El nuevo código informático es tan eficiente que en tan sólo tres días de entrenamiento, y tras jugar contra sí misma cinco millones de partidas, se convirtió en invencible. Alpha Go necesitó de meses de práctica y 30 millones de jugadas para derrotar por primera vez al mejor jugador humano.

Los científicos han elegido el Go como campo de pruebas para explorar los límites de la inteligencia artificial ya que la gran cantidad de movimientos potenciales que permite el juego, más que átomos en el universo, hacen imposible que un ordenador pueda procesarlos todos. Así, lo único que puede hacer el algoritmo es usar el reconocimiento de patrones para entender cómo se está desarrollando la partida, elaborar una estrategia y adaptarla sobre la marcha. Esta lógica se establece a través de redes neuronales artificiales, que imitan el funcionamiento del cerebro humano, y que a base de reforzar las conexiones entre ellas logran que la máquina aprenda.

Aplicaciones

Pero Go es sólo el primer paso y las aplicaciones de esta prometedora tecnología van mucho más allá de dominar un simple juego de mesa. Demis Hassabis, líder de Google Deepmind, confía en que estos avances ayuden a "resolver todo tipo de problemas apremiantes del mundo real". La predicción de las moléculas de proteínas a la hora de descubrir nuevos fármacos, el diseño de nuevos materiales o la asistencia sanitaria son algunos de los ámbitos en los que podrían aplicarse los avances en inteligencia artificial de Alpha Go Zero. Otras empresas, como IBM con su superodenador Watson, también están trabajando en este sentido.